Microsoft vous permettra de cloner votre voix pour les appels Teams, alimenté par l’IA

Dévoilé lors de la conférence annuelle Microsoft Ignite, la nouvelle fonctionnalité prolonge la puissante technologie de clonage vocal de l’entreprise.

Dévoilé lors de la conférence annuelle Microsoft Ignite, la nouvelle fonctionnalité prolonge la puissante technologie de clonage vocal de l’entreprise.

Tout comme Midjourney qui peine à reproduire les doigts, la grande majorité des IA génératives de vidéos, y compris Sora AI d’OpenAI, présentent des limitations qu’il est crucial de prendre en compte. Certes, elles réussissent à créer des vidéos de qualité remarquable. Cependant, ces modèles, selon les chercheurs, manquent de la capacité à saisir les lois de la physique.

Ce qui fait qu’en dépit des ambitions des entreprises, il est toujours ardu pour leurs modèles de reproduire le monde réel.

Cependant, une question émerge. Est-ce que cette faiblesse est liée à la qualité des données d’entraînement des modèles d’IA génératives de vidéos ?

Ou s’agit-il principalement de l’incapacité des modèles à assimiler et à comprendre les règles universelles ?

Après avoir effectué des analyses sur les modèles de génération vidéo par IA, les chercheurs ont conclu que même les plus avancés ne saisissent pas les lois de la physique.

En réalité, ils se contentent de reproduire les modèles présents dans les données d’entraînement, en se basant sur leurs caractéristiques superficielles.

Tous les modèles affichent effectivement le même schéma. Ils suivent une organisation dans le processus de création des vidéos.

<pCela dit, des modèles comme Sora AI, Dream Machine, HeyGen et Kling peuvent générer des vidéos réalistes si les prompts contiennent des données qui leur sont familières.

À l’inverse, lorsqu’ils sont confrontés à des situations non familières, les résultats obtenus sont plutôt médiocres.

Pour démontrer l’hallucination des modèles de génération de vidéos par IA, Bingyi Kang, chercheur scientifique chez TikTok, a publié une vidéo de démonstration sur X.

AGREE, naive scaling can not solve everything.

BTW, I’d like to share my favourite experiment in this paper. The setting is we have training balls moving from left to right and right to left with a fixed high speed. But if we test the model with low-speed balls, they might… pic.twitter.com/eyRhyxQrjy

— Bingyi Kang (@bingyikang) November 6, 2024

Lors de leur expérimentation, Kang et son équipe ont exposé Sora AI à un entraînement avec des projectiles se déplaçant horizontalement, dans les deux directions.

Lors des tests avec des balles à vitesse réduite, ils ont noté un comportement inattendu du modèle, qui anticipait des changements brusques de trajectoire après seulement quelques images.

Bien sûr que oui, mais pas en élargissant le modèle. Cela signifie que l’accroissement des données d’entraînement ne suffit pas à améliorer sa capacité de compréhension.

Or, c’est précisément ce qu’ont réalisé OpenAI et Google avec leurs modèles Orion et Gemini. Toutefois, cette stratégie n’autorise pas aux IA génératives de vidéos de reproduire des scénarios n’appartenant pas à leurs données d’entraînement.

Ainsi, ces systèmes limités ne peuvent pas revendiquer le statut de modèles du monde réel.

La véritable nature d’un tel modèle dépend de sa capacité de généralisation. Une compétence qui dépasse les données ayant été utilisées pour son apprentissage.

Étant donné l’impossibilité concrète de capturer toutes les nuances du monde ou de l’univers dans la constitution des données d’apprentissage, un modèle de génération de vidéos par IA doit être en mesure de comprendre et d’appliquer des principes fondamentaux, plutôt que de se limiter à la simple mémorisation de configurations établies.

De toute façon, personnellement, je suis impatient de pouvoir enfin essayer Sora AI après tant de bruit médiatique.

De la Révolution française au 6 janvier, les foules ont été héroïsées et vilipendées. Maintenant, elles constituent un champ d’étude.

Une nouvelle analyse des principales newsletters de Substack a estimé qu’environ 10 pour cent publient du contenu généré par l’IA ou assisté par l’IA.

Particle peut être personnalisé, mais l’IA gère la majeure partie des tâches. | Image : David Pierce / The Verge On pourrait dire que l’actualité en ligne traverse une période délicate. Il y a des tentatives d’affaiblir le Premier Amendement, des plateformes majeures qui ne génèrent plus autant de trafic qu’auparavant, les complexités d’un secteur publicitaire en constante transformation, et ainsi de suite. Peut-être le plus marquant est l’essor de l’IA, avec des plateformes qui absorbent une grande quantité d’informations en ligne, les transforment en une mêlée de données semi-véridiques, puis les rendent accessibles à quiconque interrogeant son chatbot sur les dernières nouvelles. C’est dans ce cadre que Particle entre en scène, une plateforme longtemps en développement, conçue par d’anciens responsables produits de Twitter, visant à faciliter la recherche et la compréhension des nouvelles pour les utilisateurs. Avec une forte dose d’IA. L’objectif de Particle est de tirer parti de l’IA pour accomplir deux tâches particulièrement bénéfiques. D’une part, elle classe de nombreux articles et reportages en collections appelées « Histoires », permettant ainsi d’accéder à une multitude d’informations et de perspectives sur un sujet donné. Certaines histoires sur Particle incluent plus de 100 articles d’actualité, des publications, des sections de citations percutantes abordant le sujet, et bien plus encore. C’est un éventail de contenu considérable. Particle exploite également l’IA pour condenser tous ces articles, juste au sommet de chaque page d’histoire. Par défaut, elle fournit une liste à puces d’informations, comme on pourrait s’y attendre de ChatGPT, mais il est possible d’ajuster la sortie de différentes manières via ce que l’application appelle les « styles de résumé ». Vous pouvez choisir « Côtés opposés » pour avoir une vue d’ensemble des deux perspectives sur la proposition de cabinet par Trump, par exemple, ou opter pour « Expliquez comme si…

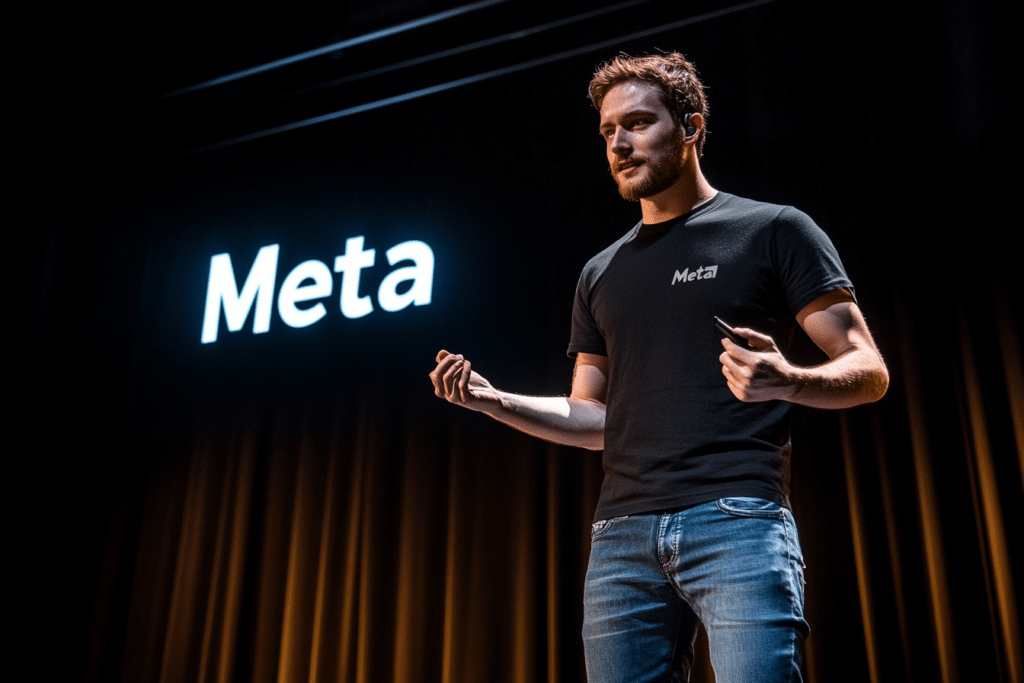

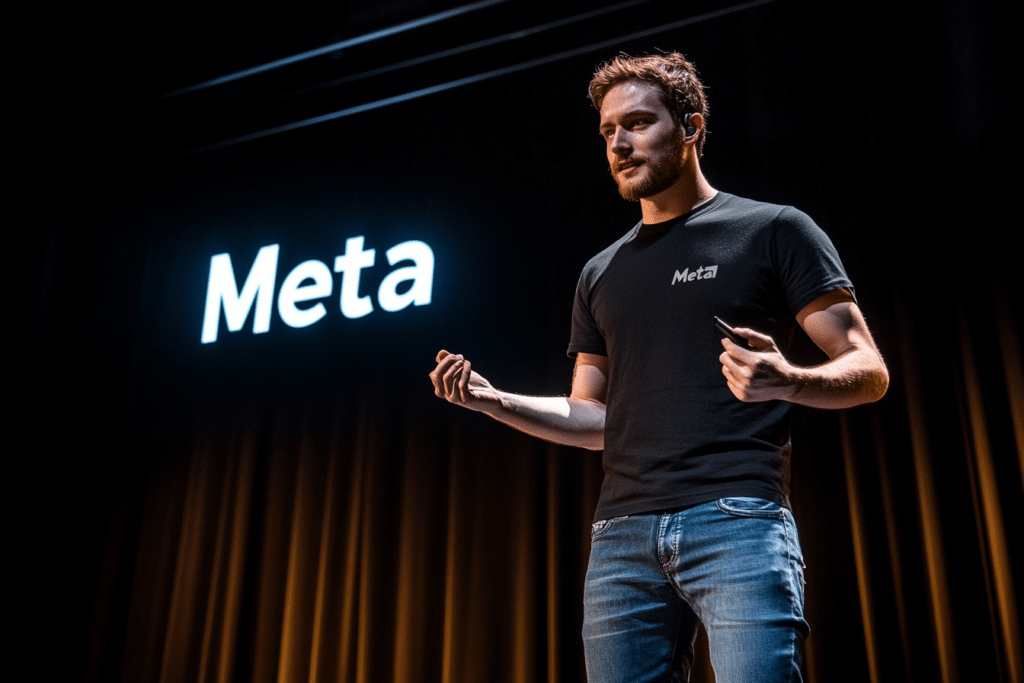

Dernières informations, Meta a décidé de fournir à l’armée américaine ses modèles d’intelligence artificielle. Qu’est-ce que cela implique pour la sécurité mondiale ? S’agit-il de la fin de la neutralité de l’IA ? Les réponses se trouvent ci-dessous !

Cette annonce a provoqué un véritable choc dans le domaine de l’intelligence artificielle. Effectivement, Meta a choisi de transmettre ses avancés modèles d’IA à l’armée des États-Unis. Cette décision a engendré de vives réactions et des inquiétudes considérables quant aux répercussions d’une telle action, surtout sur le plan éthique et géopolitique.

En permettant l’utilisation militaire de ses technologies, la société de Mark Zuckerberg prépare le terrain pour l’intégration de l’IA dans des applications militaires. D’autres nations pourraient suivre l’exemple des États-Unis, incitant la création de nouvelles startups axées exclusivement sur cette utilisation. Néanmoins, cette association soulève des interrogations majeures : que se passe-t-il lorsque des technologies destinées à améliorer notre quotidien sont détournées pour des objectifs militaires ?

Bien que les domaines de la recherche, de la santé, des médias et du commerce aient été les principaux bénéficiaires de l’IA, il semble que cette technologie entre désormais sur des terrains périlleux. Meta démontre cela en choisissant de transférer des modèles d’IA avancés à l’armée américaine.

Nous ne sommes plus dans une ère où l’IA se limite à la composition de contenu pour vos newsletters ou à l’organisation de réunions professionnelles. Elle est maintenant destinée à des applications militaires telles que la surveillance à grande échelle ou la gestion de drones armés. Ces systèmes automatisés, capables d’apprendre et de s’adapter grâce à d’énormes quantités de données, peuvent présenter d’importants avantages en termes de stratégie militaire, mais à quel prix ?

Il est essentiel de noter qu’un modèle d’IA est capable de traiter des volumes de données massifs. Cette compétence permettra aux forces armées de suivre en temps réel les zones de conflit, de anticiper les mouvements ennemis et même de rendre des décisions autonomes. D’un côté, cela pourrait simplifier la gestion des conflits, mais de l’autre, cela soulève de nombreuses interrogations. Parmi celles-ci, comment éviter les erreurs de jugement des IA ? Et en cas d’erreur, qui portera la responsabilité ?

Un des plus grands risques découlant de cette décision de Meta est la centralisation du pouvoir entre les mains de ceux qui détiennent les technologies avancées. L’armée américaine, désormais dotée de ces modèles d’IA avancés, pourrait potentiellement user de cette technologie pour surveiller et contrôler des populations civiles à l’échelle mondiale.

En effet, l’exploitation des données personnelles recueillies via les plateformes sociales pourrait permettre de mieux cibler des individus ou des groupes perçus comme menaçants pour la sécurité nationale. De surcroît, l’intégration de l’IA dans les opérations militaires accroît le risque d’escalade. Parallèlement, cela incitera d’autres puissances à entrer dans une course à l’armement technologique, exacerbant ainsi des tensions géopolitiques déjà volatiles.

🚨🇺🇸 META AI CLEARED FOR U.S. DEFENSE USE, PARTNERS WITH MILITARY CONTRACTORS

Meta has approved its AI models, Llama, for use by U.S. defense agencies and contractors, such as Lockheed Martin and Palantir.

While Meta’s AI typically restricts military applications, an exception… pic.twitter.com/58eQ5F5i50

— Mario Nawfal (@MarioNawfal) November 4, 2024

La décision de Meta de confier ses modèles d’IA les plus avancés à l’armée américaine souligne l’urgence de mettre en place des régulations internationales sur l’usage de l’IA. Cela devient d’autant plus crucial dans des domaines sensibles tels que la défense.

A l’heure actuelle, il n’existe pas de législation mondiale cohérente régissant l’application de l’IA dans les opérations militaires. Cela signifie que des entreprises comme Meta ont la latitude de vendre ou de partager des technologies extrêmement sophistiquées sans aucune contrainte légale.

Le principal enjeu est que si de telles technologies tombent entre de mauvaises mains, elles peuvent se transformer en véritables outils de contrôle et de destruction massives. Il est impératif que notre monde adopte une IA responsable, transparente et guidée par l’éthique, et non une IA exploitée comme instrument de domination et de destruction. Partagez-vous cette opinion ou pensez-vous que l’IA a sa place dans des fins militaires ? N’hésitez pas à partager vos réflexions dans les commentaires.

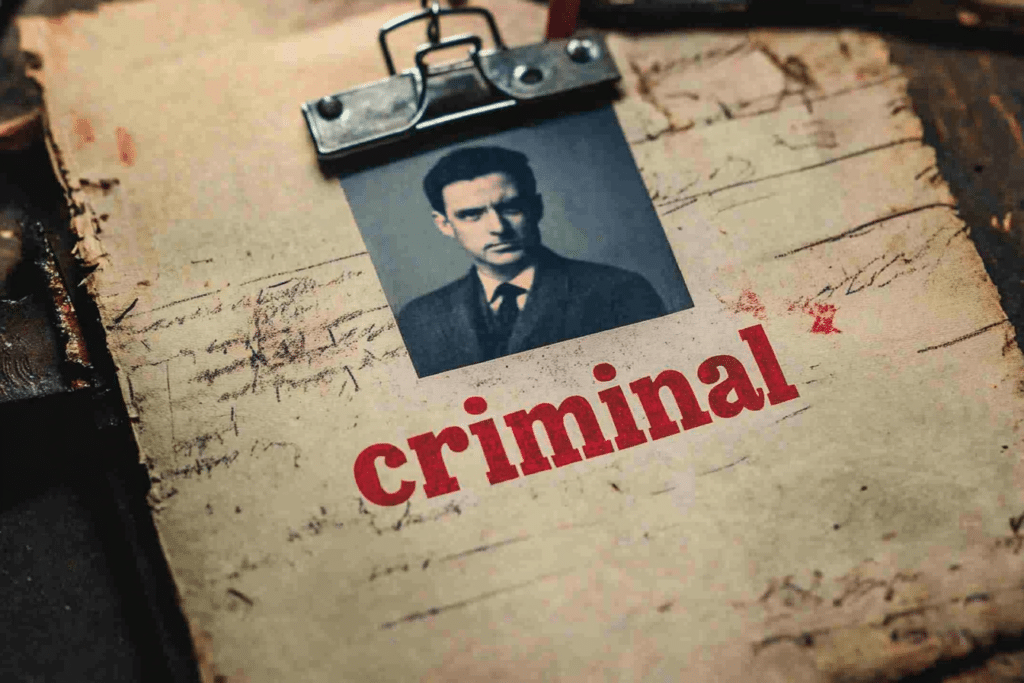

L’IA est-elle capable de commettre des erreurs et de transformer des innocents en criminels ? Plongez dans la réalité avec l’histoire de Martin Bernklau, un journaliste allemand injustement accusé par l’IA.

De nos jours, l’IA est employée dans divers secteurs et commence déjà à s’intégrer dans le domaine judiciaire et les enquêtes criminelles. Certains profileurs l’utilisent déjà pour conduire des recherches et des investigations. Mais, peut-on vraiment considérer l’IA comme infaillible à 100 % ? Voici quelques exemples, pas si isolés, qui pourraient vous donner des frissons, surtout quand l’IA fait passer des innocents pour des coupables.

Avant le triste épisode de Bernklau, des témoignages avaient déjà montré que certains systèmes d’IA, censés fournir des données précises et fiables, ont déjà mené leurs utilisateurs à des erreurs. Celles-ci sont souvent qualifiées de « hallucinations » de l’IA. Cela se produit lorsque l’outil s’égare en présentant des informations fictives comme étant factuelles.

Martin Bernklau a été confronté à cette réalité troublante lorsqu’il a fait une recherche personnelle avec Copilot de Microsoft. À sa grande surprise, l’IA le désignait comme un criminel, mentionnant des délits graves tels que des violences, des évasions d’asile et même des accusations de trafic de drogue.

Mais qu’est-il arrivé à Copilot pour accuser le journaliste de criminalité ? Simplement parce que l’IA avait amalgamé son profil personnel avec les affaires criminelles qu’il avait couvertes, reliant ainsi son nom aux crimes reportés.

Plus inquiétant encore, Copilot a divulgué des informations personnelles erronées, y compris l’adresse et le numéro de téléphone de Bernklau. Ces données inexactes, accessibles à tous, ont menacé sa sécurité et ont gravement porté atteinte à sa vie privée.

Cette expérience de Bernklau s’inscrit dans un cadre plus large. Aux États-Unis, une affaire similaire a conduit Mark Walters, un animateur radio, à poursuivre OpenAI. L’outil d’IA avait faussement affirmé que Walters était impliqué dans des activités frauduleuses, des accusations sans fondement. Ce procès pourrait créer un précédent pour les responsabilités des entreprises d’IA face à des allégations de diffamation.

L’intelligence artificielle a fait des faux pas et a faussement accusé des innocents. Ironiquement, même avec ses erreurs, l’IA dans le domaine judiciaire est de plus en plus adoptée. Son objectif est de simplifier la gestion des affaires et de générer des documents juridiques. En Inde, les tribunaux utilisent l’IA pour traduire les procès dans les dialectes locaux, facilitant ainsi la compréhension par tous les participants.

En revanche, en Australie, des tribunaux et des commissions examinent l’intégration de l’IA dans le traitement judiciaire. Cependant, Catherine Terry, avocate et présidente d’une commission sur la réforme de la justice en Australie, évoque les dangers d’une dépendance excessive. Elle affirme que « L’IA pourrait altérer la voix des témoins, qui est essentielle pour la preuve. »

C’est probablement la raison pour laquelle plusieurs tribunaux australiens, comme ceux du Queensland et de Victoria, imposent que toute utilisation d’IA dans les documents juridiques soumis à la cour soit clairement indiquée. Mais cela suffira-t-il à éviter les cas “hallucinants” d’IA dans les affaires judiciaires ?

Selon moi, il est crucial de mettre en place une réglementation stricte concernant l’IA dans le domaine de la justice. L’application de cette technologie doit être accompagnée de contrôles rigoureux. Cela évitera des erreurs graves et garantira une utilisation éthique et responsable de l’IA.

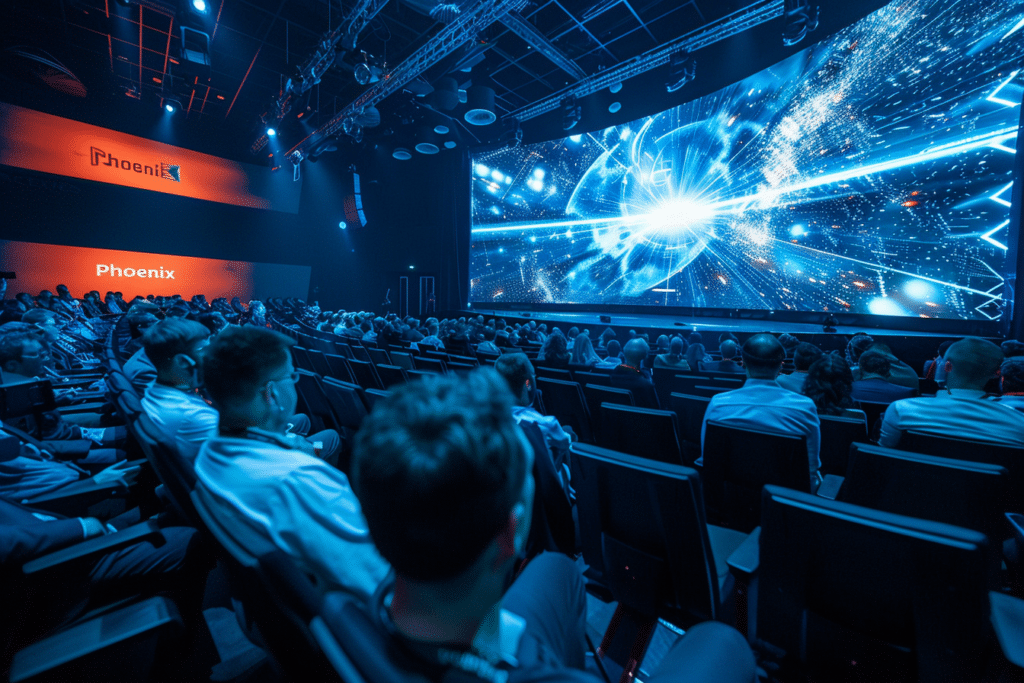

ABBYY présente Phoenix, une IA révolutionnaire destinée à perfectionner la gestion des documents des entreprises via des modèles SLM. Dévoilée lors du sommet ABBYY Ascend 2024, cette solution promet une augmentation de l’efficacité et une automatisation améliorée.

ABBYY, pionnier de l’automatisation des processus intelligents, a franchi une étape significative dans la gestion documentaire avec le lancement officiel de Phoenix le 30 octobre 2024. Cette intelligence artificielle multimodale s’appuie sur des modèles SLM pour afficher des performances proches des LLM, mais avec une efficacité supérieure. Voici les détails de cette annonce qui pourrait changer la façon dont les entreprises améliorent leur gestion documentaire.

Phoenix transcende l’idée d’un simple logiciel. Dévoilée lors de l’événement ABBYY Ascend 2024, elle fait partie intégrante du Purpose-Built AI Center, une plateforme conçue pour démocratiser l’accès à des outils d’intelligence artificielle. Ce centre vise à faciliter la création d’applications d’IA et à renforcer l’automatisation des processus. En utilisant les modèles SLM, les entreprises peuvent accroître leur retour sur investissement tout en garantissant agilité et rapidité.

Les modèles SLM d’ABBYY se distinguent par leur aptitude à intégrer aisément les documents dans les processus d’affaires. Cela garantit une réactivité face aux changements des exigences. Maxime Vermeir, Directeur Senior de la Stratégie AI chez ABBYY, a affirmé l’importance de cette innovation : « Avec le lancement de notre Purpose-Built AI Center, nous offrons à nos clients la possibilité de découvrir plus facilement la solution adaptée à leurs besoins opérationnels, simplifiant ainsi leur succès en matière d’automatisation. »

Dans le cadre de ses autres annonces marquantes, ABBYY a présenté sa solution IDP (Traitement Intelligent des Documents). Celle-ci constitue un passage sécurisé vers les LLM pour une extraction de données fiable. Ce dispositif a pour objectif de réduire le risque d’erreurs, telles que les hallucinations des modèles, et d’assurer la précision des données traitées. La sécurité et l’exactitude sont des priorités qui tiennent à cœur à l’entreprise, qui s’efforce de renforcer la confiance des utilisateurs dans la technologie. De plus, le Purpose-Built AI Center offre aux développeurs un accès centralisé à un ensemble complet d’outils d’IA. Cette plateforme prend déjà en charge plus de 80 modèles de documents, augmentant ainsi la capacité des entreprises à s’adapter et à innover dans leurs opérations quotidiennes.

ABBYY n’a pas seulement concentré ses efforts sur Phoenix et son centre AI. L’entreprise a annoncé des améliorations significatives de ses capacités OCR (Reconnaissance Optique de Caractères) pour optimiser la qualité de conversion et la détection des structures documentaires. Ces avancées permettent de traiter efficacement un volume plus important de documents tout en améliorant la mémoire et la rapidité. La reconnaissance de l’écriture cursive (ICR) est également mise en avant avec un soutien multilingue et des outils actualisés pour répondre aux besoins des entreprises en matière d’extraction de données complexes. Les développeurs profitent d’une intégration simplifiée grâce à une meilleure prise en charge des API et des langages de programmation comme .NET et Python.

Article basé sur un communiqué de presse reçu par la rédaction.

Les illusions de l’IA représentent des enjeux significatifs pour les entreprises, parfois avec des répercussions sérieuses.

Patronus AI, une jeune entreprise de San Francisco, vient de dévoiler la première API autonome créée pour remédier aux failles de l’intelligence artificielle en temps réel. Avec un financement de série A de 17 millions de dollars, cette solution identifie et empêche les erreurs produites par les systèmes d’IA avant qu’elles ne soient aperçues par les utilisateurs.

Patronus AI met en œuvre une technologie de détection avancée qui fonctionne comme un correcteur de texte pour les systèmes d’IA. Une enquête menée par l’entreprise montre que même les modèles d’IA les plus performants, tels que GPT-4, génèrent des contenus protégés dans 44 % des occurrences.

La solution de Patronus AI offre aux entreprises la possibilité de définir leurs propres paramètres de sécurité, en fonction de leurs nécessités. Grâce à une fonction nommée « judge evaluators », les utilisateurs peuvent rédiger des règles claires en anglais. Ce mécanisme aide les entreprises à protéger leurs produits de manière efficace. Il prend en compte la conformité réglementaire dans le secteur financier et la protection des données pour les acteurs de la santé.

Lynx, le modèle phare de Patronus AI, excelle dans la détection d’hallucinations. Il surpasse même GPT-4 en matière d’identification d’erreurs médicales. Ce modèle propose une version pour les analyses en temps réel ainsi qu’une autre plus exhaustive, pour les vérifications hors ligne. Parmi les outils proposés, CopyrightCatcher et FinanceBench se distinguent. Ceux-ci garantissent une protection contre le plagiat et les erreurs financières.

Le modèle tarifaire adaptable de Patronus AI débute à 10 dollars pour 1 000 requêtes d’API. Cette accessibilité pourrait séduire de nombreuses petites entreprises cherchant à surveiller l’IA. Les premiers retours d’entreprises comme HP et AngelList témoignent d’un intérêt croissant pour ce type de solution.

Avec la montée en puissance de modèles d’IA comme GPT-4, les dangers d’hallucinations augmentent. La réglementation devient plus stricte, particulièrement avec les récentes directives aux États-Unis et en Europe. Cela pousse les entreprises à s’assurer que leurs systèmes d’IA soient sûrs et conformes. La solution de Patronus AI pourrait ainsi devenir un outil central pour maintenir une sécurité continue. Cela contribuera donc à renforcer la confiance dans les systèmes d’IA.

Dans un nouveau procès pour violation du droit d'auteur contre la start-up d'IA Perplexity, Dow Jones et le New York Post soutiennent qu'il est illégal d'halluciner de fausses nouvelles et de les attribuer à de vrais journaux.

Please active sidebar widget or disable it from theme option.

{{ excerpt | truncatewords: 55 }}

{% endif %}